ทีมงาน OpenAI ทั้งหมดที่มุ่งเน้นไปที่อันตรายที่มีอยู่ของ AI ได้ลาออก หรือมีรายงานว่าถูกรวมเข้ากับกลุ่มวิจัยอื่น ๆ ภายในบริษัท

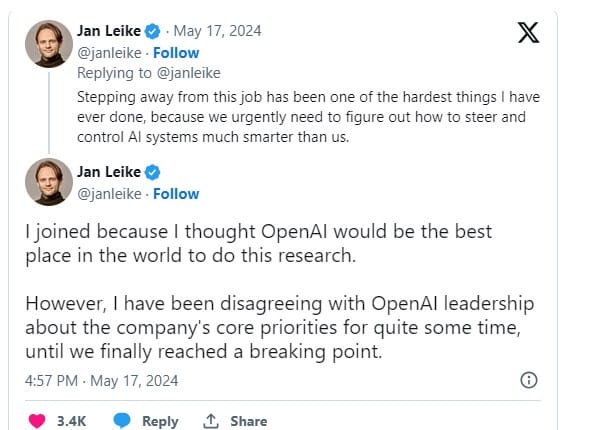

ไม่กี่วันหลังจาก Ilya Sutskever หัวหน้านักวิทยาศาสตร์ของ OpenAI และหนึ่งในผู้ร่วมก่อตั้งบริษัทประกาศลาออก ทางด้าน Jan Leike อดีตนักวิจัย DeepMind ซึ่งเป็นหัวหน้าร่วมของทีม Superalignment ของ OpenAI โพสต์บน X ว่าเขาลาออกแล้ว

ในโพสต์บน X ทาง Leike กล่าวว่าผู้นำ OpenAI ผิดพลาดในการเลือกลำดับความสำคัญหลัก และควรเน้นย้ำถึงความปลอดภัยและการเตรียมพร้อมในขณะที่การพัฒนา artificial general intelligence (AGI) ก้าวไปข้างหน้า

AGI เป็นคำที่ใช้เรียกปัญญาประดิษฐ์ที่สามารถทำงานได้เท่าหรือดีกว่ามนุษย์ในงานต่างๆ

Leike ยังวิพากษ์วิจารณ์บริษัทที่ให้ความสำคัญกับการพัฒนาผลิตภัณฑ์มากกว่าการดูแลวัฒนธรรมและกระบวนการด้านความปลอดภัย AI ที่แข็งแกร่ง โดยเขาเน้นย้ำถึงความจำเป็นเร่งด่วนในการจัดสรรทรัพยากร โดยเฉพาะพลังการประมวลผล เพื่อสนับสนุนการวิจัยด้านความปลอดภัยที่สำคัญของทีม ซึ่งเขากล่าวว่ามันถูกมองข้ามไป

“ผมไม่เห็นด้วยกับผู้นำ OpenAI เกี่ยวกับลำดับความสำคัญหลักของบริษัทมาระยะหนึ่งแล้ว จนกระทั่งในที่สุดเราก็มาถึงจุดแตกหักในช่วงไม่กี่เดือนที่ผ่านมา”

OpenAI ก่อตั้งทีมวิจัยใหม่ในเดือนกรกฎาคม 2023 เพื่อเตรียมพร้อมสำหรับการเกิดขึ้นของ AI ขั้นสูง โดย Sutskever ได้รับการแต่งตั้งให้เป็นหัวหน้าร่วมของทีมใหม่นี้ ซึ่งได้รับทรัพยากรการคำนวณของ OpenAI ถึง 20%

หลังจากการลาออกเมื่อเร็ว ๆ นี้ OpenAI ได้เลือกที่จะยุบทีม “Superalignment” และรวมฟังก์ชันเข้ากับโครงการวิจัยอื่น ๆ ภายในองค์กร โดยมีรายงานว่าการตัดสินใจครั้งนี้เป็นผลมาจากการปรับโครงสร้างภายในที่กำลังดำเนินอยู่ ซึ่งริเริ่มขึ้นเพื่อตอบสนองต่อวิกฤติการกำกับดูแลในเดือนพฤศจิกายน 2023

อ้างอิง : cointelegraph.com

ภาพ pcmag.com